GPU что это в компьютере? Что такое GPU и как это связано с видео обработкой? Что такое gpu 2

В материнской плате расположено много важных составляющих частей компьютера, которые носят свои уникальные названия: CPU, GPU, HDD, SSD, ОЗУ и так далее. Каждая из этих аббревиатур имеет свою расшифровку, но в данный момент имеет значение, что же это - GPU?

Есть схожее название с этим термином - это CPU. Многие неопытные пользователи путают эти названия, что неверно. Для начала стоит пояснить, что CPU - это центральный процессор, который является мозгом всей системы. Расшифровывается эта аббревиатура так - Central Processor Unit.

Однако стоит знать, что GPU - это тоже процессор, только графического решения. В его задачу входит обработка и вывод на экран изображения. Полное название аббревиатуры выглядит таким образом - Graphic Processing Unit.

Благодаря этим пояснениям можно понять, что GPU - это не центральный процессор, который обрабатывает только данные графического типа. Он подчиняется протоколам центрального процессора и, в отличие от него, имеет свое логическое устройство. Так же, как и у главного процессора, у графического есть ядра, только их не десятки, а тысячи. Такое большое количество ядер необходимо для получения и обработки данных, связанных с прорисовкой и временными многочисленными задачами.

Теперь, когда уже имеется общее представление о том, что GPU - это графический процессор и его задачей является обработка графических данных, можно перейти к перечислению.

На данный момент есть два вида встроенных графических процессоров - это интегрированные в материнскую плату и встроенные в процессор.

В первом варианте чип графического процессора распаян прямо на текстолите материнской платы, и мало кто знает, что это GPU. Выглядит он как обычный чип черного цвета, на котором есть наименование марки, порядковый номер и комбинация цифр, которая указывает на некоторые параметры. Так как такие графические решения не имеют собственного объема памяти, они заимствуют данный параметр у оперативной памяти, используя ее объем.

В случае со встроенным в процессор чипом его сложно увидеть, получится это только при разборе самого центрального процессора. Практически во всех процессорах нового поколения имеется дополнительное ядро, которое именуется графическим. Цена процессора при этом вырастает не намного, зато избавляет от нужды в дискретной видеокарте.

Встроенные графические процессоры позволяют сэкономить на энергопотреблении на несколько десятков процентов, что положительно сказывается на теплоотдаче. Однако есть и значительные минусы, и один из них - это низкая производительность. Такая экономная графика хорошо подходит для работы с офисными программами и приложениями, не требующими больших мощностей.

GPU в компьютере - что это такое и как его определить? Если ранее было представлено два вида графических процессоров в интегрированном виде, то далее можно рассмотреть вариант дискретной видеокарты. Исходя из этого можно понять, что GPU - это такое обозначение лишь процессора, одной из деталей которого является видеокарта. Однако эта деталь является самой важной. Еще на плате видеокарты расположены чипы памяти, конденсаторы, разъем или разъемы для питания, защитный кожух, радиатор и кулер.

Различие интегрированной и дискретной видеокарты в том, что вторая гораздо мощнее и производительнее, чем встроенный вариант. Во-первых, имеется свой объем памяти, что напрямую влияет на скорость отрисовки объектов. Во-вторых, в ее параметры входит шина расширения, битность которой позволяет увеличить пропускную способность для передачи данных.

Такие графические адаптеры требуют дополнительного питания, чтобы просто запуститься и выдавать качественное изображение. Несмотря на всю мощь, есть и офисные варианты дискретных видеокарт, которые мало чем отличаются от интегрированных собратьев. Игровые варианты более мощные по строению и потенциалу, но потребляют гораздо больше энергии.

Температурный режим

Для лучшего функционирования нужно знать, что такое GPU в компьютере и его температура. Как охладить встроенный и дискретный GPU? Для охлаждения интегрированного графического процессора достаточно разместить вентиляторы в корпусе, а у дискретных вариантов есть собственная система охлаждения. В зависимости от того, сколько вентиляторов находится над чипом, будет ясно, как хорошо охлаждается чип.

Система охлаждения видеокарты достаточно проста - чип с помощью нанесенной на него термопасты соприкасается с трубками теплоотвода, они переходят к радиатору, который охлаждается с помощью кулера.

Рабочая температура чипа составляет не более 70 градусов, дальнейшее повышение температуры можно считать перегревом. Чтобы не допустить перегрева видеокарты, достаточно своевременно прочищать от пыли видеокарту, менять при этом термопасту. Для того чтобы узнать нынешнее состояние температуры в видеокарте, достаточно запустить соответствующие программы, например, AIDA 64. Там можно увидеть температуру не только графического адаптера, но и всей системы.

Разработчику следует научиться эффективно использовать графический процессор устройства (GPU), чтобы приложение не тормозило и не выполняло лишнюю работу.

Настроить параметры GPU визуализации

Если ваше приложение тормозит, значит часть или все кадры обновления экрана обновляются больше чем 16 миллисекунд. Чтобы визуально увидеть обновления кадров на экране, можно на устройстве включить специальную опцию (Profile GPU Rendering).

У вас появится возможность быстро увидеть, сколько времени занимает отрисовка кадров. Напомню, что нужно укладываться в 16 миллисекунд.

Опция доступна на устройствах, начиная с Android 4.1. На устройстве следует активировать режим разработчика. На устройствах с версией 4.2 и выше режим по умолчанию скрыт. Для активации идёт в Настройки | О телефоне и семь раз щёлкаем по строке Номер сборки .

После активации заходим в Опции разработчика и находим пункт Настроить параметры GPU визуализации (Profile GPU rendering), который следует включить. В всплывающим окне выберите опцию На экране в виде столбиков (On screen as bars). В этом случае график будет выводиться поверх запущенного приложения.

Вы можете протестировать не только своё приложение, но и другие. Запустите любое приложение и начинайте работать с ним. Во время работы в нижней части экрана вы увидите обновляемый график. Горизонтальная ось отвечает за прошедшее время. Вертикальная ось показывает время для каждого кадра в миллисекундах. При взаимодействии с приложением, вертикальные полосы рисуются на экране, появляясь слева направо, показывая производительность кадров в течение какого-то времени. Каждый такой столбец представляет собой один кадр для отрисовки экрана. Чем выше высота столбика, тем больше времени уходит на отрисовку. Тонкая зелёная линия является ориентиром и соответствует 16 миллисекундам за кадр. Таким образом, вам нужно стремиться к тому, чтобы при изучении вашего приложения график не выбивался за эту линию.

Рассмотрим увеличенную версию графика.

Зелёная линия отвечает за 16 миллисекунд. Чтобы уложиться в 60 кадров в секунду, каждый столбец графика должен рисоваться ниже этой линии. В каких-то моментах столбец окажется слишком большим и будет гораздо выше зелёной линии. Это означает торможение программы. Каждый столбец имеет голубой, фиолетовый (Lollipop и выше), красный и оранжевый цвета.

Голубой цвет отвечает за время, используемое на создание и обновление View .

Фиолетовая часть представляет собой время, затраченное на передачу ресурсов рендеринга потока.

Красный цвет представляет собой время для отрисовки.

Оранжевый цвет показывает, сколько времени понадобилось процессору для ожидания, когда GPU завершит свою работу. Он и является источником проблем при больших величинах.

Существуют специальные методики для уменьшения нагрузки на графический процессор.

Отладить показатель GPU overdraw

Другая настройка позволяет узнать, как часто перерисовывается один и тот же участок экрана (т.е. выполняется лишняя работа). Опять идём в Опции разработчика и находим пункт Отладить показатель GPU overdraw (Debug GPU Overdraw), который следует включить. В всплывающим окне выберите опцию Показывать зоны наложения (Show overdraw areas). Не пугайтесь! Нкоторые элементы на экране изменят свой цвет.

Вернитесь в любое приложение и понаблюдайте за его работой. Цвет подскажет проблемные участки вашего приложения.

Если цвет в приложении не изменился, значит всё отлично. Нет наложения одного цвета поверх другого.

Голубой цвет показывает, что один слой рисуется поверх нижнего слоя. Хорошо.

Зелёный цвет - перерисовывается дважды. Нужно задуматься об оптимизации.

Розовый цвет - перерисовывается трижды. Всё очень плохо.

Красный цвет - перерисовывается много раз. Что-то пошло не так.

Вы можете самостоятельно проверить своё приложение для поиска проблемных мест. Создайте активность и поместите на неё компонент TextView . Присвойте корневому элементу и текстовой метке какой-нибудь фон в атрибуте android:background . У вас получится следующее: сначала вы закрасили одним цветом самый нижний слой активности. Затем поверх неё рисуется новый слой от TextView . Кстати, на самом TextView рисуется ещё и текст.

В каких-то моментах наложения цветов не избежать. Но представьте себе, что вы таким же образом установили фон для списка ListView , который занимает все площадь активности. Система будет выполнять двойную работу, хотя нижний слой активности пользователь никогда не увидит. А если вдобавок вы создадите ещё и собственную разметку для каждого элемента списка со своим фоном, то вообще получите перебор.

Маленький совет. Поместите после метода setContentView() вызов метода, который уберёт перирисовку экрана цветом темы. Это поможет убрать одно лишнее наложение цвета:

GetWindow().setBackgroundDrawable(null);

Процессоры и графические ускорители очень похожи, они оба сделаны из сотен миллионов транзисторов и могут обрабатывать тысячи операций за секунду. Но чем именно отличаются эти два важных компонента любого домашнего компьютера?

В данной статье мы попытаемся очень просто и доступно рассказать, в чем отличие CPU от GPU. Но сначала нужно рассмотреть два этих процессора по отдельности.

CPU (Central Processing Unit или же Центральное Процессорное Устройство) часто называют "мозгом" компьютера. Внутри центрального процессора расположено около миллиона транзисторов, с помощью которых производятся различные вычисления. В домашних компьютерах обычно устанавливаются процессоры, имеющие от 1 до 4 ядер с тактовой частотой приблизительно от 1 ГГц до 4 ГГц.

Процессор является мощным, потому что может делать все. Компьютер способен выполнить какую-либо задачу, так как процессор способен выполнить эту задачу. Программистам удалось достичь этого благодаря широким наборам инструкций и огромным спискам функций, совместно используемых в современных центральных процессорах.

Что такое GPU?

GPU (Graphics Processing Unit или же Графическое Процессорное Устройство) представляет собой специализированный тип микропроцессора, оптимизированный для очень специфических вычислений и отображения графики. Графический процессор работает на более низкой тактовой частоте в отличие от процессора, но имеет намного больше процессорных ядер.

Также можно сказать, что GPU - это специализированный CPU, сделанный для одной конкретной цели - рендеринг видео. Во время рендеринга графический процессор огромное количество раз выполняет несложные математические вычисления. GPU имеет тысячи ядер, которые будут работать одновременно. Хоть и каждое ядро графического процессора медленнее ядра центрального процессора, это все равно эффективнее для выполнения простых математических вычислений, необходимых для отображения графики. Этот массивный параллелизм является тем, что делает GPU способным к рендерингу сложной 3D графики, требуемой современными играми.

Отличие CPU и GPU

Графический процессор может выполнить лишь часть операций, которые может выполнить центральный процессор, но он делает это с невероятной скоростью. GPU будет использовать сотни ядер, чтобы выполнить срочные вычисления для тысяч пикселей и отобразить при этом сложную 3D графику. Но для достижения высоких скоростей GPU должен выполнять однообразные операции.

Возьмем, например, Nvidia GTX 1080. Данная видеокарта имеет 2560 шейдерных ядер. Благодаря этим ядрам Nvidia GTX 1080 может выполнить 2560 инструкций или операций за один такт. Если вы захотите сделать картинку на 1% ярче, то GPU с этим справится без особого труда. А вот четырехъядерный центральный процессор Intel Core i5 сможет выполнить только 4 инструкции за один такт.

Тем не менее, центральные процессоры более гибкие, чем графические. Центральные процессоры имеют больший набор инструкций, поэтому они могут выполнять более широкий диапазон функций. Также CPU работают на более высоких максимальных тактовых частотах и имеют возможность управлять вводом и выводом компонентов компьютера. Например, центральный процессор может интегрироваться с виртуальной памятью, которая необходима для запуска современной операционной системы. Это как раз то, что графический процессор выполнить не сможет.

Вычисления на GPU

Даже несмотря на то, что графические процессоры предназначены для рендеринга, они способны на большее. Обработка графики - это только вид повторяющихся параллельных вычислений. Другие задачи, такие как майнинг Bitcoin и взломы паролей полагаются на одни и те же виды массивных наборов данных и простых математических вычислений. Именно поэтому некоторые пользователи используют видеокарты для не графических операций. Такое явление называется GPU Computation или же вычисления на GPU.

Выводы

В данной статье мы провели сравнение CPU и GPU. Думаю, всем стало понятно, что GPU и CPU имеют схожие цели, но оптимизированы для разных вычислений. Пишите свое мнение в комментариях, я постараюсь ответить.

Все мы знаем, что у видеокарты и процессора несколько различные задачи, однако знаете ли вы, чем они отличаются друг от друга во внутренней структуре? Как CPU (англ. - central processing unit ), так и GPU (англ. - graphics processing unit ) являются процессорами, и между ними есть много общего, однако сконструированы они были для выполнения различных задач. Подробнее об этом вы узнаете из данной статьи.

CPU

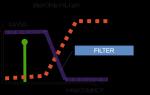

Основная задача CPU, если говорить простыми словами, это выполнение цепочки инструкций за максимально короткое время. CPU спроектирован таким образом, чтобы выполнять несколько таких цепочек одновременно или разбивать один поток инструкций на несколько и, после выполнения их по отдельности, сливать их снова в одну, в правильном порядке. Каждая инструкция в потоке зависит от следующих за ней, и именно поэтому в CPU так мало исполнительных блоков, а весь упор делается на скорость выполнения и уменьшение простоев, что достигается при помощи кэш-памяти и конвейера .

GPU

Основная функция GPU - рендеринг 3D графики и визуальных эффектов, следовательно, в нем все немного проще: ему необходимо получить на входе полигоны, а после проведения над ними необходимых математических и логических операций, на выходе выдать координаты пикселей. По сути, работа GPU сводится к оперированию над огромным количеством независимых между собой задач, следовательно, он содержит большой объем памяти, но не такой быстрой, как в CPU, и огромное количество исполнительных блоков: в современных GPU их 2048 и более, в то время как у CPU их количество может достигать 48, но чаще всего их количество лежит в диапазоне 2-8.

Основные отличия

CPU отличается от GPU в первую очередь способами доступа к памяти. В GPU он связанный и легко предсказуемый - если из памяти читается тексел текстуры, то через некоторое время настанет очередь и соседних текселов. С записью похожая ситуация - пиксель записывается во фреймбуфер, и через несколько тактов будет записываться расположенный рядом с ним. Также графическому процессору, в отличие от универсальных процессоров, просто не нужна кэш-память большого размера, а для текстур требуются лишь 128–256 килобайт. Кроме того, на видеокартах применяется более быстрая память, и в результате GPU доступна в разы большая пропускная способность, что также весьма важно для параллельных расчетов, оперирующих с огромными потоками данных.

Есть множество различий и в поддержке многопоточности: CPU исполняет 1– 2 потока вычислений на одно процессорное ядро, а GPU может поддерживать несколько тысяч потоков на каждый мультипроцессор, которых в чипе несколько штук! И если переключение с одного потока на другой для CPU стоит сотни тактов, то GPU переключает несколько потоков за один такт.

В CPU большая часть площади чипа занята под буферы команд, аппаратное предсказание ветвления и огромные объемы кэш-памяти, а в GPU большая часть площади занята исполнительными блоками. Вышеописанное устройство схематично изображено ниже:

Разница в скорости вычислений

Если CPU - это своего рода «начальник», принимающий решения в соответствии с указаниями программы, то GPU - это «рабочий», который производит огромное количество однотипных вычислений. Выходит, что если подавать на GPU независимые простейшие математические задачи, то он справится значительно быстрее, чем центральный процессор. Данным отличием успешно пользуются майнеры биткоинов.

Майнинг Bitcoin

Суть майнинга заключается в том, что компьютеры, находящиеся в разных точках Земли, решают математические задачи, в результате которых создаются биткоины . Все биткоин-переводы по цепочке передаются майнерам, чья работа состоит в том, чтобы подобрать из миллионов комбинаций один-единственный хэш, подходящий ко всем новым транзакциям и секретному ключу, который и обеспечит майнеру получение награды в 25 биткоинов за раз. Так как скорость вычисления напрямую зависит от количества исполнительных блоков, получается, что GPU значительно лучше подходят для выполнения данного типа задачи, нежели CPU. Чем больше количество произведенных вычислений, тем выше шанс получить биткоины. Дело даже дошло до сооружения целых ферм из видеокарт:

GPU (Graphics Processing Unit) является электронным устройством, разработанным для построения и обработки 2D или 3D изображения с последующим его выводом на экран. GPU широко используются в настольных компьютерных системах, мобильных телефонах, серверах и игровых консолях.

Применение GPUСовременные графические чипы устанавливаются на платах компьютерных видеокарт или интегрируются в материнские платы с целью экономии занимаемого компьютером пространства.

GPU позволяют эффективно обрабатывать компьютерную графику, что делает их самой используемой разновидностью чипов для вывода графической информации на экран. Впервые термин GPU был применен в 1999 г. компанией Nvidia на презентации видеокарты GeForce 256, которая на тот момент была самой производительной платой компании. Процессор модели мог обрабатывать около 10 млн графических полигонов в секунду.ФункцииGPU состоит из специальных транзисторов, большинство которых используется для обработки трехмерных изображений. Изначально графические процессоры были созданы с целью ускорения построения текстур и скорости обработки графических полигонов компьютерами, однако позднее графические ядра научились производить геометрические вычисления, что также ускорило скорость и качество показа изображений. Последние разработки в GPU включают в себя активацию поддержки программируемых шейдеров, технологии для уменьшения эффектов наложения элементов изображения друг на друга. Также новые графические процессоры способны более точно передавать цвета на монитор. Современные видеокарты поддерживают потоковую трансляцию видеоизображения с различных источников, подключенных через специальные интерфейсы.Типы GPUГрафические платы можно разделить на три типа: дискретные, встроенные и гибридные. Дискретные видеокарты устанавливаются в отдельный слот на материнской плате компьютера или портативного устройства (ноутбука) через специальный интерфейс (например, PCI-Express или AGP). Данная разновидность GPU имеет наиболее мощные производительные характеристики за счет особой структуры видеомодуля и его мощностных показателей. Также при необходимости дискретная видеокарта может быть с легкостью заменена на плату другой модели. Такие технологии, как SLI или CrossFire, позволяют объединять несколько видеоплат, чтобы еще больше улучшить производительность графической подсистемы.Встроенные GPU используются в портативных устройствах и имеют скромные вычислительные показатели из-за малого размера платы, а также сложностей их систем охлаждения и структурных особенностей. Гибридные видеокарты являются новым классом адаптеров, которые призваны заменить встроенные и дискретные модули. Новая технология создается с целью увеличения скорости обмена данными с системной оперативной памятью и процессором для улучшения производительности графики в целом. Гибридная карточка может быть встроена в материнскую плату, но при этом работать на базе технологии дискретных видеокарт PCI-Express.